Así es Indexifembedded, la nueva meta etiqueta de Google

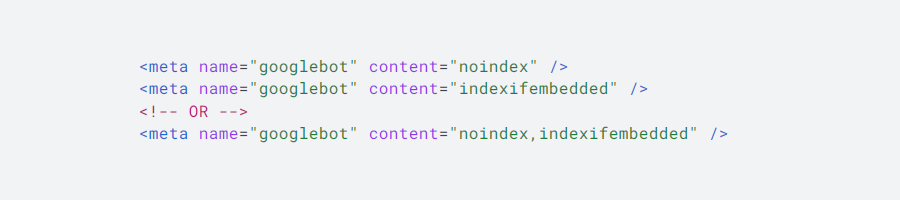

El pasado 21 de enero, Google presentó una nueva etiqueta del robots.txt denominada ‘indexifembedded‘, destinada a maximizar el control sobre el momento en que se indexa un contenido en el buscador.

Como probablemente sepas, el archivo robots.txt contiene un conjunto de directrices para las arañas de rastreo de Google y otros motores de búsqueda. En esencia, permite indicarles qué páginas pueden o no indexar, además de establecer la prioridad y comunicar otros parámetros a estos rastreadores. En este documento se emplean multitud de metaetiquetas —’noindex’, ‘follow’, ‘nosnippet’, etcétera—, y desde principios de año, Indexifembedded ha pasado a engrosar esta lista.

En concreto, la nueva etiqueta de robots.txt está pensada para indicar a los googlebots que debe indexar el contenido cuando esté insertado o ‘embebido’ (embedded) mediante inline frame o iframes, una etiqueta HTML que posibilita la incrustación, en un marco, de contenido de otra página web en la nuestra. Por ejemplo, si el código de un vídeo de YouTube o de un mensaje de Twitter apareciera entre iframes en una página marcada con el atributo ‘noindex’, el webmaster podría ordenar a los googlebots que indexe ese contenido en particular por medio de la etiqueta indexifembedded. Expresado de otra forma, las etiquetas ‘noindex’ y ‘indexifembedded’ pueden convivir en una misma página web sin generar un conflicto con el documento robots.txt.

«La etiqueta indexifembedded soluciona un problema habitual que afecta especialmente a los editores de redes sociales: aunque quieran que su contenido se indexe cuando esté insertado en páginas externas, no significa que quieran que sus páginas de redes sociales se indexen por sí solas. Por ese motivo, utilizan una etiqueta ‘noindex’ en esas páginas. Sin embargo, durante la indexación, la etiqueta noindex también impide insertar el contenido en otras páginas», aclaran los autores Weizi Wang y Gary en una publicación del Centro de la Búsqueda de Google.

SEO y robots.txt: ¿cómo se interrelacionan en beneficio de la búsqueda online?

Las directivas presentes en el archivo robots.txt permiten a los webmasters ‘comunicarse’ con los indexadores de cada motor de búsqueda, un eslabón esencial en la cadena de posicionamiento online. Gracias al elemento del protocolo HTTP conocido como ‘user-agent’, es posible transmitir una información a un grupo de rastreadores en particular. Los más utilizados son los siguientes:

Respecto a los beneficios que resultan de la interdependencia entre las etiquetas del robots.txt y las estrategias SEO, pueden citarse los siguientes:

Reducción del contenido duplicado

El contenido publicado es uno de los grandes males de internet, razón por la que acarrea importantes penalizaciones de Google, que persigue esta y otras prácticas incompatibles con sus directrices de calidad. Sin embargo, la duplicación de páginas puede producirse de manera accidental por una mala configuración de las categorías y las etiquetas en el CMS. El uso de las directivas del robots.txt permite combatir este problema.

Aprovechamiento del ‘crawl budget’

El presupuesto de rastreo, o crawl budget, se define como el tiempo que los rastreadores del buscador dedican a revisar e indexar las páginas de un sitio web. Dado que este tiempo es limitado, optimizar el archivo robots.txt es una buena forma de agilizar la indexación de contenidos, son sobrecargar el ancho de banda del servidor web.

Indexación restringida de ciertas páginas

Directivas como ‘index’ o ‘noimageindex’ están pensadas para indicar a los rastreadores del buscador qué páginas pueden o no indexar en las SERPs. De este modo, se obtiene un mayor control sobre el contenido que acaba engrosando el ranking de los motores de búsqueda —pero como se explicará más adelante, Google y otros buscadores pueden ignorar estas restricciones.

Por otra parte, las etiquetas del robots.txt benefician al sitio web de muchas otras formas: evitando que el servidor web pueda sobrecargarse y provocar caídas; respetando la privacidad de determinadas páginas y secciones web; limitando la indexación de material audiovidual y de recursos web que interese ocular en las SERPs, etcétera.

Anteriormente, se ha mencionado que directivas como ‘noindex’ permiten limitar la indexación de páginas en las SERPs del buscador, pero ¿realmente pueden excluirse contenidos utilizando las etiquetas del archivo robots.txt? Aunque buscadores como Google no suelen indexar páginas bloqueadas en este archivo, no puede garantizarse que no suceda lo contrario, más aún si ha sido enlazado por terceros.

Según la información facilitada en la Central de Búsqueda de Google, «no utilices un archivo robots.txt como medio para ocultar tus páginas web de los resultados de búsqueda de Google. Si otras páginas apuntan a tu página con texto descriptivo, Google aún podría indexar la URL sin visitar la página». Entonces, ¿cómo evitar la indexación de páginas de manera eficaz? Agregando un encabezado ‘noindex’ en la respuesta del Protocolo de Transferencia de Hipertexto (HTTP). Cuando los rastreadores web revisen la página con este encabezado, bloquearán su indexación hasta nuevo aviso.

¿Qué otras etiquetas se utilizan en el robots.txt y cuál es su función?

‘Index’ y ‘noindex’

Estas etiquetas se utilizan para indicar a las arañas de rastreo que deben o no indexar un contenido determinado. En el caso de ‘index’, es la etiqueta predeterminada, por lo que las páginas que no incluyan el atributo ‘noindex’ enviarán la directriz de indexar a los motores de búsqueda.

‘Follow’ y ‘nofollow’

Incluso si la página en cuestión no debe ser indexada, los rastreadores de Google, Bing, etcétera, seguirán los enlaces situados en la misma. Para restringir este seguimiento, se utiliza la etiqueta ‘nofollow’, mientras que la etiqueta ‘follow’ emite el mensaje opuesto. Una vez más, en el contenido que no haya sido marcado con etiqueta ‘nofollow’, los rastreadores interpretarán que deben seguir todos los enlaces.

‘Noimageindex’

Con esta etiqueta se ordena al buscador que no debe indexar ninguna de las imágenes publicadas en la página. Otra solución sería el empleo del atributo ‘disallow’ para el conjunto de rastreadores de Google Imágenes (Googlebot-Image) y sus homólogos de Bing, Yandex, DuckDuckGo, etcétera.

‘None’

Esta etiqueta permite economizar en el uso de dos ya mencionadas, ‘noindex’ y ‘nofollow’. Es decir, indicaría a los rastreadores del buscador que no deben indexar ni seguir los enlaces de una página determinada.

‘All’

Contrariamente a la anterior, esta etiqueta reitera a los googlebots la directiva de que no hay límites de indexación ni de publicación. Dado que los contenidos son percibidos por defecto de esta manera, es una etiqueta sin utilidad real.

‘Nosnippet’

Mediante esta etiqueta se ordena a las arañas de rastreo que no deben mostrar fragmentos de texto, ni vistas previas de vídeo en las SERPs del buscador. Existe un uso generalizado de los rich snippets, lo que se hace evidente en el crecimiento de las búsquedas ‘zero clics’ en tiempos recientes.

‘Notranslate’

Como indica su nombre, esta etiqueta previene que Google y otros motores de búsqueda muestren extractos traducidos en las SERPs. En caso contrario —que la etiqueta no sea incluida—, el buscador se tomará la libertad de traducir el título y la descripción para aquellos usuarios que realicen búsquedas en un idioma diferente.

Otras etiquetas

Resumidamente, otras etiquetas más o menos habituales en el archivo robots.txt son (1) ‘noarchive’, que señala a los rastreadores que no deben mostrar en las SERPs los enlaces en caché de una página determinada; (2) ‘nocache’, que cumple una función similar a ‘noarchive’, con la salvedad de que sólo se emplea en navegadores como Firefox e Internet Explorer, y (3) ‘unavailable_after’, una etiqueta desconocida por la mayoría y que sirve para indicar a los googlebots que debe ignorar un contenido pasada una fecha específica.

Tabla de contenidos